|

Bên trong con chip 10,000 USD quan trọng nhất thế giới AI

Phần mềm có thể viết các đoạn văn bản hoặc vẽ những bức tranh giống như do con người tạo ra đang tạo nên một cơn sốt trong ngành công nghệ.

“Con ngựa thồ” của giới AI

Các “gã khổng lồ” như Microsoft và Google đang đấu tranh để tích hợp công nghệ AI tiên tiến vào công cụ tìm kiếm của họ, trong khi các công ty như OpenAI và Stable Diffusion cũng chạy đua ra mắt phần mềm.

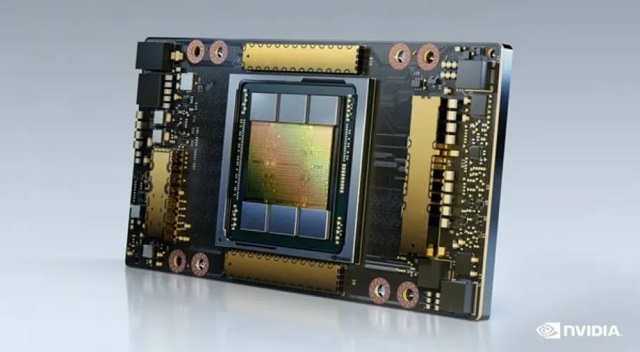

Cung cấp sức mạnh cho nhiều ứng dụng này chính là một con chip trị giá khoảng 10,000 USD, thứ đã trở thành một trong những công cụ quan trọng nhất trong ngành trí tuệ nhân tạo: Nvidia A100.

Nathan Benaich, một nhà đầu tư chuyên xuất bản bản tin và báo cáo về ngành AI, cho biết A100 đã trở thành “con ngựa thồ” của các chuyên gia trí tuệ nhân tạo vào thời điểm hiện tại. Theo New Street Research, Nvidia chiếm 95% thị trường bộ xử lý đồ họa có thể được sử dụng cho máy học.

A100 rất phù hợp với mô hình máy học cung cấp năng lượng cho các công cụ như ChatGPT, Bing AI hay Stable Diffusion. Nó có thể thực hiện đồng thời nhiều phép tính đơn giản – một điều rất quan trọng đối với việc đào tạo và sử dụng các mô hình mạng nơron thần kinh nhân tạo.

Công nghệ đằng sau A100 ban đầu được sử dụng để hiển thị đồ họa 3D phức tạp trong trò chơi. Nó thường được gọi là bộ xử lý đồ họa hoặc GPU, nhưng ngày nay A100 của Nvidia được định cấu hình và nhắm mục tiêu vào các tác vụ máy học và chạy trong các trung tâm dữ liệu.

Những công ty lớn hoặc startup đang phát triển phần mềm như chatbot và trình tạo hình ảnh cần tới hàng trăm hoặc hàng nghìn con chip của Nvidia. Họ sẽ phải tự mua chúng hoặc tiếp cận tới các máy tính chứa chúng từ một nhà cung cấp dịch vụ đám mây.

Cần có hàng trăm GPU để huấn luyện các mô hình trí tuệ nhân tạo, chẳng hạn như các mô hình ngôn ngữ lớn. Các con chip cần phải đủ mạnh để xử lý hàng terabyte dữ liệu một cách nhanh chóng. Các GPU như A100 cũng cần thiết để “suy luận” hoặc sử dụng mô hình ngôn ngữ để tạo văn bản, đưa ra dự đoán hoặc xác định đối tượng bên trong ảnh.

Điều này có nghĩa là các công ty AI cần quyền truy cập vào một lượng lớn A100. Một số doanh nhân trong lĩnh vực AI thậm chí còn coi số lượng A100 mà họ có quyền truy cập là dấu hiệu của sự tiến bộ.

Stability AI là công ty đã giúp phát triển Stable Diffusion, một công cụ tạo hình ảnh đã thu hút sự chú ý vào mùa thu năm ngoái và được cho là có mức định giá hơn 1 tỷ USD. Một năm trước, họ có 32 chiếc A100, nhưng giờ đây, họ có quyền truy cập tới hơn 5,400 GPU A100, theo một ước tính từ báo cáo State of AI – đơn vị theo dõi những công ty và trường đại học nào có bộ sưu tập GPU A100 lớn nhất.

Nvidia A100

|

Siêu hệ thống DGX A100

So với các loại phần mềm khác, chẳng hạn như phục vụ một trang web, đôi khi sử dụng sức mạnh xử lý theo từng đợt trong vài phần triệu giây, các tác vụ máy học có thể chiếm toàn bộ sức mạnh xử lý của máy tính, đôi khi trong hàng giờ hoặc hàng ngày. Điều này có nghĩa là các công ty có sản phẩm AI thành công thường cần mua thêm GPU để xử lý các giai đoạn cao điểm hoặc cải thiện mô hình của họ.

Những GPU này không hề rẻ. Nhiều trung tâm dữ liệu sử dụng một hệ thống bao gồm tám GPU A100 hoạt động cùng nhau. Hệ thống này, DGX A100 của Nvidia, có giá đề xuất gần 200,000 USD, mặc dù nó vẫn đi kèm các con chip cần thiết. Nvidia cho biết họ sẽ bán trực tiếp quyền truy cập đám mây vào các hệ thống DGX, điều này có thể giúp giảm chi phí đầu vào cho những nhà nghiên cứu.

Một ước tính từ New Street Research cho thấy mô hình ChatGPT nếu nằm bên trong công cụ tìm kiếm của Bing có thể yêu cầu 8 GPU để đưa ra câu trả lời cho một câu hỏi trong vòng chưa đầy một giây. Với tốc độ đó, Microsoft sẽ cần hơn 20,000 máy chủ 8 GPU chỉ để triển khai mô hình ChatGPT trong Bing cho mọi người. Điều này cho thấy Microsoft có thể tiêu tốn 4 tỷ USD cho tính năng này.

Tương tự, nếu muốn mở rộng theo quy mô của Google, nơi phục vụ 8 hoặc 9 tỷ truy vấn mỗi ngày, “gã khổng lồ” thực sự cần phải chi 80 tỷ USD cho hệ thống DGX, Antoine Chkaiban, chuyên gia phân tích công nghệ tại New Street Research cho biết.

Phiên bản mới nhất của Stable Diffusion đã được đào tạo trên 256 GPU A100, tức là 32 máy với 8 con chip A100 mỗi máy, mang lại tổng cộng là 200,000 giờ tính toán, theo thông tin do Stability AI đăng.

Theo giá thị trường, chỉ riêng việc đào tạo mô hình đó đã có giá 600,000 USD, giám đốc điều hành của Stability AI cho biết trên Twitter. Điều đó chưa tính đến chi phí “suy luận”, hay triển khai mô hình.

CEO của Nvidia, Jensen Huang nói rằng GPU của Nvidia cho phép các công ty khởi nghiệp đào tạo các mô hình với chi phí thấp hơn nhiều so với việc họ sử dụng bộ xử lý máy tính truyền thống. “Bây giờ bạn có thể xây dựng thứ gì đó giống như mô hình ngôn ngữ lớn, chẳng hạn như GPT, với giá khoảng 10, 20 triệu USD”, ông Huang nói.

Cạnh tranh gia tăng

Nvidia không phải là công ty duy nhất sản xuất GPU để sử dụng trí tuệ nhân tạo. AMD và Intel cũng có bộ xử lý đồ họa cạnh tranh và các công ty điện toán đám mây lớn như Google và Amazon đang phát triển và triển khai chip của riêng họ được thiết kế đặc biệt cho khối lượng công việc AI.

Tuy nhiên, “phần cứng AI vẫn được hợp nhất chặt chẽ với NVIDIA,” theo báo cáo State of AI Compute Index. Tính đến tháng 12/2022, hơn 21,000 nghiên cứu nguồn mở về AI cho biết họ đã sử dụng chip Nvidia.

Hầu hết các nhà nghiên cứu được khảo sát đã sử dụng V100, chip của Nvidia ra mắt vào năm 2017, nhưng A100 đã phát triển nhanh chóng vào năm 2022 để trở thành chip Nvidia được sử dụng nhiều thứ ba.

A100 cũng có điểm khác biệt, nó là một trong số ít chip được áp dụng các biện pháp kiểm soát xuất khẩu vì lý do quốc phòng. Mùa thu năm ngoái, Nvidia cho biết chính phủ Mỹ đã áp đặt yêu cầu giấy phép cấm xuất khẩu A100 và H100 sang Trung Quốc, bao gồm Hồng Kông, và Nga.

Cuộc cạnh tranh khốc liệt nhất cho A100 có thể là người kế nhiệm của nó. A100 được giới thiệu lần đầu tiên vào năm 2020. Còn chip H100, được giới thiệu vào năm 2022, đang bắt đầu được sản xuất với số lượng lớn. Trên thực tế, Nvidia đã ghi nhận doanh thu từ chip H100 trong quý kết thúc vào tháng 1/2023 cao hơn so với A100, mặc dù H100 đắt hơn.

Nvidia cho biết họ muốn đào tạo AI nhanh hơn 1 triệu phần trăm. Điều đó có thể có nghĩa là, cuối cùng, các công ty AI sẽ không cần nhiều chip Nvidia như vậy.

Nvidia lợi lớn

Nvidia sẽ được hưởng lợi từ cuộc chạy đua AI hiện tại. Trong báo cáo kết quả kinh doanh quý 4/2022, tổng doanh thu của công ty này giảm giảm 21%, song mảng kinh doanh chip AI của công ty tăng 11% lên hơn 3.6 tỷ USD, ghi nhận sự tăng trưởng liên tục.

Cổ phiếu của Nvidia đã tăng 65% tính đến thời điểm hiện tại của năm 2023, vượt xa S&P 500 và các cổ phiếu bán dẫn khác.

Giám đốc điều hành Nvidia, Jensen Huang, liên tục nói về AI trong cuộc gặp với các nhà phân tích gần đây, đồng thời khẳng định sự trí tuệ nhân tạo sẽ là trung tâm trong chiến lược của công ty.

Kim Dung (Theo CNBC)

FILI

|